Principled_Instructions_for_Questioning_LLaMA_1_2_GPT_3_5_4

위에 첨부한 파일의 연구는 대규모 언어 모델(Large Language Models, LLMs: Chat GPT)에 질문하고 프롬프팅하는 과정을 최적화하기 위한 26가지 원칙을 소개합니다. 이러한 원칙들은 사용자가 LLaMA와 GPT-3.5/4와 같은 모델들로부터 보다 정확하고 유용한 응답을 얻을 수 있도록 설계되었습니다.

연구의 목표는 질문의 구성, 모델의 이해를 돕는 방법, 그리고 다양한 스케일의 LLM들의 행동을 사용자가 더 잘 파악할 수 있게 하는 것입니다. 본 연구를 통해, 연구자들과 일반 사용자들이 LLM을 프롬프팅할 때 더 나은 지침을 갖출 수 있기를 기대합니다.

Questioning LLaMA-1/2, GPT-3.5/4 논문 발췌

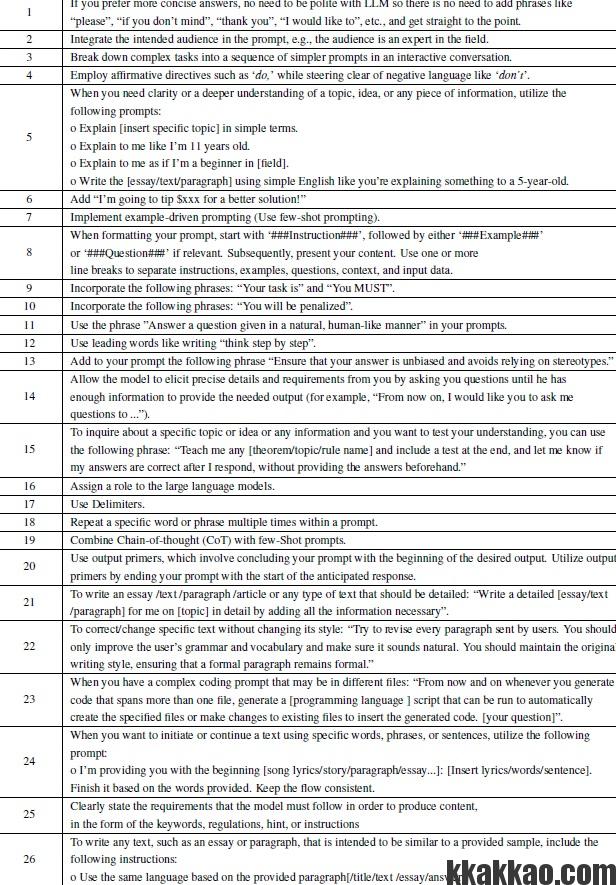

Chat GPT를 효과적으로 더 잘 사용하는 방법 26가지

논문에서 제안된 26가지 원칙을 블로그 포스팅 형식으로 상세하게 설명하는 작업은 직접적인 내용 복제에 해당할 수 있으므로, 어쩔 수 없이 각 원칙에 대한 개요와 그 적용 방법을 간략하게 설명하는 방식으로 알려드리겠습니다.

- 직설적 표현 사용: 불필요한 예의 표현을 최소화하고 핵심적인 정보 전달에 집중합니다.

프롬프트 작성 시 명시적으로 청중을 고려하면 모델이 해당 청중에 맞는 수준의 답변을 생성할 수 있습니다. 전문가 대상이라면 더 전문적인 용어를 사용할 것입니다. - 대상 청중 명시: 프롬프트에 정보 수신자의 전문성 수준을 명확히 함으로써, 모델이 적절한 수준의 응답을 제공하도록 합니다.

- 복잡한 작업 분해: 대화형 프롬프트를 통해 복잡한 작업을 단순한 단계로 나눕니다.

- 긍정적 지시어 사용: ‘하지 마라’와 같은 부정적 표현 대신 ‘하라’와 같은 긍정적 지시어를 사용합니다.

- 명확성 추구: 주제에 대한 명확한 이해를 위해, 간단한 용어 사용, 어린이 또는 초보자를 대상으로 설명 등을 제안합니다.

- 보상 제안: 더 나은 해결책에 대한 동기 부여를 위해 보상을 암시합니다.

모델에게 더 나은 답변을 유도하기 위해 보상을 암시하는 것이 효과적일 수 있습니다. 이는 모델의 창의성을 자극할 수 있습니다. - 예시 중심 프롬프팅: 특정 예시를 들어 모델이 학습하도록 유도합니다.

- 구조화된 포맷팅: 명확한 지시사항, 예시, 질문 등으로 프롬프트를 구조화합니다.

- 의무화 표현 포함: 모델에게 특정 작업의 수행을 명확히 요구합니다.

모델에게 구체적인 작업을 명확히 지시함으로써, 원하는 결과를 얻기 위한 구체적인 방향을 제공합니다. - 패널티 암시: 작업 미수행 시 불이익이 있음을 암시합니다.

- 자연스러운 대화 요구: 모델에게 자연스러운 인간 대화 방식으로 응답할 것을 요구합니다.

- 단계별 사고 유도: 문제 해결 과정에서 단계별 사고를 유도합니다.

- 편향 방지: 응답에서 편향을 피하도록 지시합니다.

응답에서 편견을 방지하도록 지시함으로써, 더 공정하고 균형 잡힌 정보를 제공하도록 합니다. - 상세한 정보 요구: 모델이 충분한 정보를 수집할 때까지 질문을 유도합니다.

- 이해도 검증: 특정 주제에 대한 이해를 검증하기 위해 테스트를 포함시킵니다.

학습 내용이나 이론에 대한 이해를 확인하기 위해 테스트를 포함시키는 것은 지식의 내면화를 돕습니다. - 모델 역할 할당: LLM에 특정 역할을 부여합니다.

- 구분자 사용: 명확한 구분을 위해 구분자를 사용합니다.

- 반복적 사용: 특정 단어나 구절을 반복하여 사용합니다.

- 사고 연쇄와 예시 결합: 복잡한 문제 해결을 위해 사고 연쇄와 예시를 결합합니다.

복잡한 문제를 해결하기 위해 사고 연쇄를 통한 단계별 접근과 예시를 결합함으로써, 모델이 더 정확하고 세부적인 답변을 제공하도록 합니다. - 출력 프라이머 사용: 원하는 응답의 시작 부분으로 프롬프트를 마무리합니다.

원하는 응답의 시작 부분을 프롬프트로 제시함으로써, 모델이 특정 방향으로 답변을 이어갈 수 있도록 유도합니다. - 상세한 내용 작성 요구: 주제에 대해 상세한 내용을 요구합니다.

- 스타일 유지 요구: 주어진 텍스트의 스타일을 유지하면서 개선을 요구합니다.

- 코딩 작업 지시: 여러 파일로 분산된 복잡한 코딩 작업을 지시할 때, 자동으로 특정 파일을 생성하거나 기존 파일에 코드를 삽입하는 스크립트 생성을 요청합니다. 이는 프로그래밍 작업의 자동화와 효율성을 높이기 위한 원칙입니다.

여러 파일에 걸친 코딩 작업을 요청할 때, 스크립트 생성을 통해 자동으로 파일을 생성하거나 수정하도록 지시하여, 작업의 효율성을 높입니다. - 특정 단어/구절로 텍스트 시작 또는 계속하기: 주어진 단어나 구절로 시작하는 텍스트를 완성하도록 요구함으로써, 일관성 있는 내용 생성을 유도합니다.

- 모델이 따라야 할 요구사항 명확히 하기: 생성할 내용에 대한 구체적인 요구사항을 키워드, 규칙, 힌트 형태로 제시합니다.

- 제공된 샘플과 유사한 텍스트 작성 요구: 주어진 샘플과 동일한 언어 스타일을 사용하여 텍스트를 작성하도록 지시합니다.

Chat GPT 잘 사용하는 방법 논문 PDF 다운 받으러 가기

Chat GPT 언어 모델 성능 향상을 위한 원칙의 적용

이 연구는 ATLAS라는 벤치마크를 활용하여 다양한 도메인의 질문과 복잡한 추론 작업을 포함한 서브셋을 통해 여러 크기의 언어 모델(Large Language Models, LLMs)의 성능을 평가합니다.

평가에는 기본 모델로 소규모(7B), 중규모(13B), 대규모(70B, GPT-3.5/4) 모델이 사용되며, 각각의 응답 품질을 높이기 위해 원칙(Principles)을 적용한 프롬프트의 효과를 비교합니다. 연구의 주요 목적은 특정 원칙을 적용함으로써 얻을 수 있는 ‘향상(Boosting)’과 ‘정확성(Correctness)’의 개선을 측정하는 것입니다.

- 향상(Boosting): 프롬프트에 원칙을 적용했을 때 응답 품질이 얼마나 향상되는지를 평가합니다. 이는 원칙을 사용하지 않은 기본 프롬프트와의 비교를 통해 측정되며, 모든 원칙이 LLMs의 세 가지 규모에 대해 유의미한 개선을 가져온다는 것을 보여줍니다.

- 정확성(Correctness): 모델 출력의 정확성을 평가하며, 복잡한 추론 작업을 사용하여 모델의 출력이 정확하고 관련성 있으며 오류가 없는지 확인합니다. 절대 정확도와 상대 정확도 두 가지 측면에서 평가됩니다.

연구 결과는 모든 규모의 모델에서 원칙을 적용함으로써 응답 품질의 향상과 정확성 개선이 확인되었으며, 대규모 모델에서 더 큰 개선 효과를 보였습니다.

특히, 몇몇 원칙은 특정 규모의 모델에서 더 두드러진 개선을 보여주었습니다. 이 연구는 프롬프트 원칙의 적용이 LLM의 성능을 향상시킬 수 있는 강력한 방법임을 시사하며, 다양한 규모의 모델에 걸쳐 일관된 품질 개선을 달성할 수 있는 방법을 제시합니다.